인공지능 거버넌스 체계를 둘러싼 논의가 몇년 간 지속되다가 유럽연합(EU)이 지난해 중반 리스크 단계별로 엄격하고 상세한 규제 방안을 포함한 'AI법'을 전격적으로 채택하면서 전 세계적으로 하나의 이정표를 기록하게 됐다.

이후 대한민국이 지난해 말 인공지능공지능 거버넌스 체계를 둘러싼 논의가 몇년 간 지속되다가 유럽연합(EU)이 지난해 중반 리스크 단계별로 엄격하고 상세한 규제 방안을 포함한 'AI법'을 전격적으로 채택하면서 전 세계적으로 하나의 이정표를 기록하게 됐다.

이후 대한민국 국회가 지난해 말 『인공지능 발전과 신뢰 기반 조성 등에 관한 기본법』(AI기본법)을 전격적으로 통과시킨 데 이어 올해 초에는 대통령 탄핵 사태에도 불구하고 이 법이 공포될 예정이어서 세계 주요국(사법권역) 가운데 두 번째로 별도 AI 거버넌스 법을 갖춘 나라가 됐다.

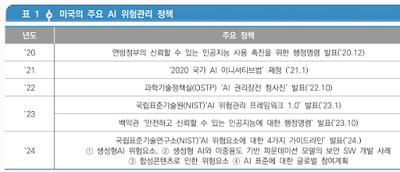

하지만, 미국 등 많은 나라는 여전히 별도 법 채택보다는 기존 관련법을 개정하거나 행정명령이나 가이드라인, 규정 및 규칙 등으로 AI 관련 정책을 규율하는 방식을 선호하고 있다. 이와 관련해 정보통기획평가원(IITP)에서 미국의 AI 규제 정책 체계를 소개하고, 그 가운데 AI 위험 관리 체계 마련에 주도적인 역할을 하는 국립표준기술원(이하 NIST)의 최근 발표를 정리한 보고서를 발간했다.

특히 이 보고서에는 미국 연방 상무부 산하 기관으로써 과학․표준․기술 등의 진보와 미국의 혁신과 산업경쟁력의 증진을 목표로 여러 기능을 수행하고 있는 NIST가 2023년 11월 조 바이든 대통령이 발표한 ‘AI 행정명령’의 후속 조치로 발표한 4가지 지침을 정리해 소개하고 있다.

여기서는 보고서의 도입 부분을 소개하고 보고서 링크를 맨 아래 공유한다.

◎ 미국은 혁신과 진흥을 도모하는 관점에서 AI 위험을 관리

미국의 AI 규제는 AI 사용 증진, 위험관리, 국방 등의 다양한 분야에서 연방법과 개별 주법 체계로 논의를 진행 중이며, 기업들은 자발적인 위험 대응 환경 구축을 선언

- 연방 차원에서 강력한 법적 규제보다는 위험관리 관점에서 AI 혁신과 진흥을 도모하기 위한 다양한 보고서와 지침으로 AI 정책 방향 제시에 무게

- 다만, 생성형 AI로 각종 위험이 증가함에 따라 연방의회도 AI 혁신과 진흥을 할 수 있는 입법을 본격 논의 중

- 주 정부 차원에서는 콜로라도 주가 고위험 AI 시스템에 대한 규제를 담은 AI법을 제정(’24.5.)하는 등 개별적으로 규제를 시도 중

- 미국의 빅테크 기업 16개는 AI 제품의 안전성 테스트, 외부 테스트, 잠재적인 위험 평가 등을 포함하는 ‘AI 안전서약’에 서명하며 자발적으로 AI 위험 관리를 시도

- (1차 7개, ‘23.7.21) 아마존, 앤트로픽, 구글, 인플렉션, 메타, MS, 오픈AI / (2차 8개, ’23.9.12) 어도비, 코히어, 엔비디아, IBM, 팔란티어, 세일즈포스, 스케일 AI, 스태빌리티 / (3차 1개, ‘24.7.26) 애플 등 총 16개

- 정부는 AI의 가능성을 실현하고 위험을 피하기 위한 강력한 조치로 ‘안전하고 신뢰할 수 있는 AI에 대한 행정명령(이하 AI 행정명령, ’23.10)’을 발표하고 8대 원칙 제시

- ▲안전‧보안, ▲생태계, ▲책임, ▲형평성과 시민권, ▲소비자보호, ▲개인정보보호, ▲위험관리, ▲글로벌 리더십 등

- 특히, 안전과 보안을 제고하기 위한 조치 중 하나로 미국 상무부 장관의 주된 책임 하에 AI 안전‧보안 관련 세부 규정 마련을 요구

국립표준기술원(이하 NIST)은 美 연방 상무부 산하 기관으로써 과학․표준․기술 등의 진보와 미국의 혁신과 산업경쟁력의 증진을 목표로 여러 기능을 수행

- (NIST 조직 구성) 표준‧기술 담당 상무부 차관보 겸 이사를 중심으로 ▲미국 반도체 지원법(CHIPS for America) 지원, ▲커뮤니케이션․엔지니어링‧재료‧중성자 등 실험실 프로그램 지원, ▲혁신‧산업 서비스 지원, ▲경영 지원 부서 등 NIST는 AI와 관련된 기본․응용 작업을 10년 이상 수행하며, AI가 사람이나 지구에 위해를 가하지 않고 상업적․사회적 혜택을 실현할 수 있도록 지원

- 특히, ‘AI 위험관리 프레임워크(’23.1)’로 AI 관련 조직에 필수 지침을 제공해 왔으며 AI 행정명령이 AI 안전성‧보안을 위한 새로운 기준 수립을 지시함에 따라,

- ① AI 위험관리 프레임워크 : 생성형 AI 프로파일 ② 생성형 AI와 이중 용도 기반 파운데이션 모델의 보안 SW 개발 사례, ③ 합성콘텐츠로 인한 위험 요소, ④ AI 표준에 대한 글로벌 참여계획 등 4가지 지침을 발표

- NIST 내에는 안전연구소(’23.11)도 설립‧운영되고 있으며, 자국 기업 중심으로 구성된 5개 분야의 민간 컨소시엄을 발족해 레드티밍, 역량평가 등을 수행

◎ 본 보고서는 NIST가 ‘AI 행정명령’의 후속 조치로 발표한 4가지 지침의 주요 내용을 살펴보고 시사점을 제공하고자 함

가. AI 위험관리 프레임워크 : 생성형 AI 프로파일(NIST AI 600-1, ’24.7. Artificial Intelligence Risk Management Framework: Generative Artificial Intelligence Profile)

나. 생성형 AI와 이중 용도 기반 파운데이션 모델의 보안 SW 개발 사례(NIST SP 800-218A, ’24.7. Secure Software Development Practices for Generative AI and Dual-Use Foundation Models - An SSDF Community Profile)

다. 합성 콘텐츠로 인한 위험 감소(NIST AI 100-4, ’24.11. Reducing Risks Posed by Synthetic Content)

라. AI 표준에 대한 글로벌 참여 계획(NIST AI 100-5, ’24.7. A Plan for Global Engagement on AI Standards)

※ 상세한 내용은 아래 링크에서 보고서 원문을 다운로드받아 볼 수 있다